Tecnología Moderna

Este blog quiere ayudar a los estudiantes de todo el mundo ;)

sábado, 7 de noviembre de 2015

domingo, 25 de octubre de 2015

martes, 13 de octubre de 2015

Historia de la Computadora

COMPUTADORA

Máquina capaz de efectuar una secuencia de operaciones mediante un programa, de tal manera, que se realice un procesamiento sobre un conjunto de datos de entrada, obteniéndose otro conjunto de datos de salida.

TIPOS DE COMPUTADORAS

Se clasifican de acuerdo al principio de operación de Analógicas y Digitales.

- COMPUTADORA ANALÓGICA

- Aprovechando el hecho de que diferentes fenómenos físicos se describen por relaciones matemáticas similares (v.g. Exponenciales, Logarítmicas, etc.) pueden entregar la solución muy rápidamente. Pero tienen el inconveniente que al cambiar el problema a resolver, hay que realambrar la circuitería (cambiar el Hardware).

- COMPUTADORA DIGITAL

- Están basadas en dispositivos biestables, i.e., que sólo pueden tomar uno de dos valores posibles: ‘1’ ó ‘0’. Tienen como ventaja, el poder ejecutar diferentes programas para diferentes problemas, sin tener que la necesidad de modificar físicamente la máquina.

HISTORIA DE LA COMPUTACIÓN

Uno de los primeros dispositivos mecánicos para contar fue el ábaco, cuya historia se remonta a las antiguas civilizaciones griega y romana. Este dispositivo es muy sencillo, consta de cuentas ensartadas en varillas que a su vez están montadas en un marco rectangular. Al desplazar las cuentas sobre varillas, sus posiciones representan valores almacenados, y es mediante dichas posiciones que este representa y almacena datos. A este dispositivo no se le puede llamar computadora por carecer del elemento fundamental llamado programa.

Otro de los inventos mecánicos fue la Pascalina inventada por Blaise Pascal (1623 - 1662) de Francia y la de Gottfried Wilhelm von Leibniz (1646 - 1716) de Alemania. Con estas máquinas, los datos se representaban mediante las posiciones de los engranajes, y los datos se introducían manualmente estableciendo dichas posiciones finales de las ruedas, de manera similar a como leemos los números en el cuentakilómetros de un automóvil.

La primera computadora fue la máquina analítica creada por Charles Babbage, profesor matemático de la Universidad de Cambridge en el siglo XIX. La idea que tuvo Charles Babbage sobre un computador nació debido a que la elaboración de las tablas matemáticas era un proceso tedioso y propenso a errores. En 1823 el gobierno Británico lo apoyo para crear el proyecto de una máquina de diferencias, un dispositivo mecánico para efectuar sumas repetidas.

Mientras tanto Charles Jacquard (francés), fabricante de tejidos, había creado un telar que podía reproducir automáticamente patrones de tejidos leyendo la información codificada en patrones de agujeros perforados en tarjetas de papel rígido. Al enterarse de este método Babbage abandonó la máquina de diferencias y se dedico al proyecto de la máquina analítica que se pudiera programar con tarjetas perforadas para efectuar cualquier cálculo con una precisión de 20 dígitos. La tecnología de la época no bastaba para hacer realidad sus ideas.

El mundo no estaba listo, y no lo estaría por cien años más.

En 1944 se construyó en la Universidad de Harvard, la Mark I, diseñada por un equipo encabezado por Howard H. Aiken. Esta máquina no está considerada como computadora electrónica debido a que no era de propósito general y su funcionamiento estaba basado en dispositivos electromecánicos llamados relevadores.

En 1947 se construyó en la Universidad de Pennsylvania la ENIAC (Electronic Numerical Integrator And Calculator) que fue la primera computadora electrónica, el equipo de diseño lo encabezaron los ingenieros John Mauchly y John Eckert. Esta máquina ocupaba todo un sótano de la Universidad, tenía más de 18 000 tubos de vacío, consumía 200 KW de energía eléctrica y requería todo un sistema de aire acondicionado, pero tenía la capacidad de realizar cinco mil operaciones aritméticas en un segundo.

El proyecto, auspiciado por el departamento de Defensa de los Estados Unidos, culminó dos años después, cuando se integró a ese equipo el ingeniero y matemático húngaro John von Neumann (1903 - 1957). Las ideas de von Neumann resultaron tan fundamentales para su desarrollo posterior, que es considerado el padre de las computadoras.

La EDVAC (Electronic Discrete Variable Automatic Computer) fue diseñada por este nuevo equipo. Tenía aproximadamente cuatro mil bulbos y usaba un tipo de memoria basado en tubos llenos de mercurio por donde circulaban señales eléctricas sujetas a retardos.

La idea fundamental de von Neumann fue: permitir que en la memoria coexistan datos con instrucciones, para que entonces la computadora pueda ser programada en un lenguaje, y no por medio de alambres que eléctricamente interconectaban varias secciones de control, como en la ENIAC.

Todo este desarrollo de las computadoras suele divisarse por generaciones y el criterio que se determinó para determinar el cambio de generación no está muy bien definido, pero resulta aparente que deben cumplirse al menos los siguientes requisitos:

- La forma en que están construidas.

- Forma en que el ser humano se comunica con ellas.

Primera Generación

En esta generación había una gran desconocimiento de las capacidades de las computadoras, puesto que se realizó un estudio en esta época que determinó que con veinte computadoras se saturaría el mercado de los Estados Unidos en el campo de procesamiento de datos.

Esta generación abarco la década de los cincuenta. Y se conoce como la primera generación. Estas máquinas tenían las siguientes características:

- Estas máquinas estaban construidas por medio de tubos de vacío.

- Eran programadas en lenguaje de máquina.

En esta generación las máquinas son grandes y costosas (de un costo aproximado de ciento de miles de dólares).

En 1951 aparece la UNIVAC (NIVersAl Computer), fue la primera computadora comercial, que disponía de mil palabras de memoria central y podían leer cintas magnéticas, se utilizó para procesar el censo de 1950 en los Estados Unidos.

En las dos primeras generaciones, las unidades de entrada utilizaban tarjetas perforadas, retomadas por Herman Hollerith (1860 - 1929), quien además fundó una compañía que con el paso del tiempo se conocería como IBM (International Bussines Machines).

Después se desarrolló por IBM la IBM 701 de la cual se entregaron 18 unidades entre 1953 y 1957.

Posteriormente, la compañía Remington Rand fabricó el modelo 1103, que competía con la 701 en el campo científico, por lo que la IBM desarrollo la 702, la cual presentó problemas en memoria, debido a esto no duró en el mercado.

La computadora más exitosa de la primera generación fue la IBM 650, de la cual se produjeron varios cientos. Esta computadora que usaba un esquema de memoria secundaria llamado tambor magnético, que es el antecesor de los discos actuales.

Otros modelos de computadora que se pueden situar en los inicios de la segunda generación son: la UNIVAC 80 y 90, las IBM 704 y 709, Burroughs 220 y UNIVAC 1105.

Segunda Generación

Cerca de la década de 1960, las computadoras seguían evolucionando, se reducía su tamaño y crecía su capacidad de procesamiento. También en esta época se empezó a definir la forma de comunicarse con las computadoras, que recibía el nombre de programación de sistemas.

Las características de la segunda generación son las siguientes:

- Están construidas con circuitos de transistores.

- Se programan en nuevos lenguajes llamados lenguajes de alto nivel.

En esta generación las computadoras se reducen de tamaño y son de menor costo. Aparecen muchas compañías y las computadoras eran bastante avanzadas para su época como la serie 5000 de Burroughs y la ATLAS de la Universidad de Manchester.

Algunas de estas computadoras se programaban con cintas perforadas y otras más por medio de cableado en un tablero. Los programas eran hechos a la medida por un equipo de expertos: analistas, diseñadores, programadores y operadores que se manejaban como una orquesta para resolver los problemas y cálculos solicitados por la administración. El usuario final de la información no tenía contacto directo con las computadoras. Esta situación en un principio se produjo en las primeras computadoras personales, pues se requería saberlas "programar" (alimentarle instrucciones) para obtener resultados; por lo tanto su uso estaba limitado a aquellos audaces pioneros que gustaran de pasar un buen número de horas escribiendo instrucciones, "corriendo" el programa resultante y verificando y corrigiendo los errores o bugs que aparecieran. Además, para no perder el "programa" resultante había que "guardarlo" (almacenarlo) en una grabadora de astte, pues en esa época no había discos flexibles y mucho menos discos duros para las PC; este procedimiento podía tomar de 10 a 45 minutos, según el programa. El panorama se modificó totalmente con la aparición de las computadoras personales con mejore circuitos, más memoria, unidades de disco flexible y sobre todo con la aparición de programas de aplicación general en donde el usuario compra el programa y se pone a trabajar. Aparecen los programas procesadores de palabras como el célebre Word Star, la impresionante hoja de cálculo (spreadsheet) Visicalc y otros más que de la noche a la mañana cambian la imagen de la PC. El sortware empieza a tratar de alcanzar el paso del hardware. Pero aquí aparece un nuevo elemento: el usuario.

El usuario de las computadoras va cambiando y evolucionando con el tiempo. De estar totalmente desconectado a ellas en las máquinas grandes pasa la PC a ser pieza clave en el diseño tanto del hardware como del software. Aparece el concepto de human interface que es la relación entre el usuario y su computadora. Se habla entonces de hardware ergonómico (adaptado a las dimensiones humanas para reducir el cansancio), diseños de pantallas antirreflejos y teclados que descansen la muñeca. Con respecto al software se inicia una verdadera carrera para encontrar la manera en que el usuario pase menos tiempo capacitándose y entrenándose y más tiempo produciendo. Se ponen al alcance programas con menús (listas de opciones) que orientan en todo momento al usuario (con el consiguiente aburrimiento de los usuarios expertos); otros programas ofrecen toda una artillería de teclas de control y teclas de funciones (atajos) para efectuar toda suerte de efectos en el trabajo (con la consiguiente desorientación de los usuarios novatos). Se ofrecen un sinnúmero de cursos prometiendo que en pocas semanas hacen de cualquier persona un experto en los programas comerciales. Pero el problema "constante" es que ninguna solución para el uso de los programas es "constante". Cada nuevo programa requiere aprender nuevos controles, nuevos trucos, nuevos menús. Se empieza a sentir que la relación usuario-PC no está acorde con los desarrollos del equipo y de la potencia de los programas. Hace falta una relación amistosa entre el usuario y la PC.

Las computadoras de esta generación fueron: la Philco 212 (esta compañía se retiró del mercado en 1964) y la UNIVAC M460, la Control Data Corporation modelo 1604, seguida por la serie 3000, la IBM mejoró la 709 y sacó al mercado la 7090, la National Cash Register empezó a producir máquinas para proceso de datos de tipo comercial, introdujo el modelo NCR 315.

La Radio Corporation of America introdujo el modelo 501, que manejaba el lenguaje COBOL, para procesos administrativos y comerciales. Después salió al mercado la RCA 601.

Tercera generación

Con los progresos de la electrónica y los avances de comunicación con las computadoras en la década de los 1960, surge la tercera generación de las computadoras. Se inaugura con la IBM 360 en abril de 1964.3

Las características de esta generación fueron las siguientes:

- Su fabricación electrónica esta basada en circuitos integrados.

- Su manejo es por medio de los lenguajes de control de los sistemas operativos.

La IBM produce la serie 360 con los modelos 20, 22, 30, 40, 50, 65, 67, 75, 85, 90, 195 que utilizaban técnicas especiales del procesador, unidades de cinta de nueve canales, paquetes de discos magnéticos y otras características que ahora son estándares (no todos los modelos usaban estas técnicas, sino que estaba dividido por aplicaciones).

El sistema operativo de la serie 360, se llamó OS que contaba con varias configuraciones, incluía un conjunto de técnicas de manejo de memoria y del procesador que pronto se convirtieron en estándares.

En 1964 CDC introdujo la serie 6000 con la computadora 6600 que se consideró durante algunos años como la más rápida.

En la década de 1970, la IBM produce la serie 370 (modelos 115, 125, 135, 145, 158, 168). UNIVAC compite son los modelos 1108 y 1110, máquinas en gran escala; mientras que CDC produce su serie 7000 con el modelo 7600. Estas computadoras se caracterizan por ser muy potentes y veloces.

A finales de esta década la IBM de su serie 370 produce los modelos 3031, 3033, 4341. Burroughs con su serie 6000 produce los modelos 6500 y 6700 de avanzado diseño, que se reemplazaron por su serie 7000. Honey - Well participa con su computadora DPS con varios modelos.

A mediados de la década de 1970, aparecen en el mercado las computadoras de tamaño mediano, o minicomputadoras que no son tan costosas como las grandes (llamadas también como mainframes que significa también, gran sistema), pero disponen de gran capacidad de procesamiento. Algunas minicomputadoras fueron las siguientes: la PDP - 8 y la PDP - 11 de Digital Equipment Corporation, la VAX (Virtual Address eXtended) de la misma compañía, los modelos NOVA y ECLIPSE de Data General, la serie 3000 y 9000 de Hewlett - Packard con varios modelos el 36 y el 34, la Wang y Honey - Well -Bull, Siemens de origen alemán, la ICL fabricada en Inglaterra. En la Unión Soviética se utilizó la US (Sistema Unificado, Ryad) que ha pasado por varias generaciones.

Cuarta Generación

Aquí aparecen los microprocesadores que es un gran adelanto de la microelectrónica, son circuitos integrados de alta densidad y con una velocidad impresionante. Las microcomputadoras con base en estos circuitos son extremadamente pequeñas y baratas, por lo que su uso se extiende al mercado industrial. Aquí nacen las computadoras personales que han adquirido proporciones enormes y que han influido en la sociedaden general sobre la llamada "revolución informática".

En 1976 Steve Wozniak y Steve Jobs inventan la primera microcomputadora de uso masivo y más tarde forman la compañía conocida como la Apple que fue la segunda compañía más grande del mundo, antecedida tan solo por IBM; y esta por su parte es aún de las cinco compañías más grandes del mundo.

En 1981 se vendieron 800 00 computadoras personales, al siguiente subió a 1 400 000. Entre 1984 y 1987 se vendieron alrededor de 60 millones de computadoras personales, por lo que no queda duda que su impacto y penetración han sido enormes.

Con el surgimiento de las computadoras personales, el software y los sistemas que con ellas de manejan han tenido un considerable avance, porque han hecho más interactiva la comunicación con el usuario. Surgen otras aplicaciones como los procesadores de palabra, las hojas electrónicas de cálculo, paquetes gráficos, etc. También las industrias del Software de las computadoras personales crece con gran rapidez, Gary Kildall y William Gates se dedicaron durante años a la creación de sistemas operativos y métodos para lograr una utilización sencilla de las microcomputadoras (son los creadores de CP/M y de los productos de Microsoft).

No todo son microcomputadoras, por su puesto, las minicomputadoras y los grandes sistemas continúan en desarrollo. De hecho las máquinas pequeñas rebasaban por mucho la capacidad de los grandes sistemas de 10 o 15 años antes, que requerían de instalaciones costosas y especiales, pero sería equivocado suponer que las grandes computadoras han desaparecido; por el contrario, su presencia era ya ineludible en prácticamente todas las esferas de control gubernamental, militar y de la gran industria. Las enormes computadoras de las series CDC, CRAY, Hitachi o IBM por ejemplo, eran capaces de atender a varios cientos de millones de operaciones por segundo.

Quinta Generación

En vista de la acelerada marcha de la microelectrónica, la sociedad industrial se ha dado a la tarea de poner también a esa altura el desarrollo del software y los sistemas con que se manejan las computadoras. Surge la competencia internacional por el dominio del mercado de la computación, en la que se perfilan dos líderes que, sin embargo, no han podido alcanzar el nivel que se desea: la capacidad de comunicarse con la computadora en un lenguaje más cotidiano y no a través de códigos o lenguajes de control especializados.

Japón lanzó en 1983 el llamado "programa de la quinta generación de computadoras", con los objetivos explícitos de producir máquinas con innovaciones reales en los criterios mencionados. Y en los Estados Unidos ya está en actividad un programa en desarrollo que persigue objetivos semejantes, que pueden resumirse de la siguiente manera:

- Procesamiento en paralelo mediante arquitecturas y diseños especiales y circuitos de gran velocidad.

- Manejo de lenguaje natural y sistemas de inteligencia artificial.

martes, 6 de octubre de 2015

Nanotecnologia

La nanotecnología trabaja con materiales y estructuras cuyas magnitudes se miden en nanómetros, lo cual equivale a la milmillonésima parte de un metro. Un nanomaterial tiene propiedades morfológicas más pequeñas que una décima de micrómetro en, al menos, una dimensión; en otras palabras, considerando que los materiales deben tener alto, ancho y largo, una de estas tres dimensiones es menor a la décima parte de un metro dividido en 1 millón.

Esta ciencia aplicada se desarrolla a nivel de átomos y moléculas. La química, la biología y la física son algunos de los campos de aplicación de la nanotecnología, que aparece como una esperanza para la solución de diversos problemas.

Uno de los primeros pasos en el desarrollo de la nanotecnología ha sido la comprensión del ADN como un actor clave en la regulación de los procesos del organismo. Las moléculas, por lo tanto, demuestran ser determinantes en los procesos de vida.

La nanomedicina, por otra parte, es la rama de la medicina que aprovecha los conocimientos de la nanotecnología en los procedimientos destinados al cuidado de la salud. En este contexto, una de sus potenciales aplicaciones es el desarrollo de robots a escala nanométrica, que fuesen capaces de ingresar en el cuerpo humano y completar distintas actividades, como puede ser la búsqueda y la destrucción de células cancerígenas o la reparación de fisuras en los tejidos óseos.

Se conoce como nanotecnología avanzada a la ingeniería de nanosistemas que opera a escala molecular. Esta disciplina trabaja con productos creados a partir de una cierta disposición de los átomos.

Se conoce como nanotecnología avanzada a la ingeniería de nanosistemas que opera a escala molecular. Esta disciplina trabaja con productos creados a partir de una cierta disposición de los átomos.

Los críticos de la nanotecnología han mencionado diversos riesgos vinculados a su desarrollo, como la toxicidad potencial de la nueva clase de nanosustancias o la posible aparición de una denominada plaga gris (donde los nanorobots se autorreplicarían sin control hasta consumir toda la materia viva del planeta).

Es importante señalar que la nanotecnología requiere de la participación de diversos campos del conocimiento, tales como la química, la biología molecular, la informática y la medicina, entre otras ciencias. Cada una aporta la teoría y el trabajo práctico necesario para que las otras puedan partir de una base sobre la cual investigar y desarrollar, razón por la que esta tecnología es llamada convergente. En otras palabras, gracias a la nanotecnología, las barreras que dividen el saber científico se derriban, potenciando la complejidad de los resultados.

La inversión en nanotecnología

Varios países cuyas economías están atravesando un pleno desarrollo económico, invierten considerables sumas económicas y mano de obra especializada en investigar las potenciales aplicaciones de la nanotecnología. Como se menciona anteriormente, la nanomedicina presenta tentadoras oportunidades al ser humano, especialmente cuando se considera que podría mejorar diversas prácticas y procedimientos, tales como los diagnósticos, las curaciones, la administración de medicamentos y las cirugías.

A nivel mundial, el número de laboratorios que destina importantes porcentajes a la investigación de este tipo de tecnología ronda los cuarenta. Por otro lado, alrededor de trescientas compañías llevan el prefijo nano en sus nombres, aunque esto no se refleje en las ofertas de productos disponibles en el mercado.

Con respecto a la informática, se sabe que colosos de la talla de IBM, Intel y NEC, entre otros, invierten sumas millonarias año a año en sus departamentos de Investigación y Desarrollo, lo cual repercute en las características de los componentes que fabrican. Asimismo, los gobiernos de los países más desarrollados muestran mucho interés en la nanotecnología, y sus apuestas monetarias superan por decenas las que pueden realizar las empresas recién mencionadas.

Pero la nanotecnología podría mejorar muchos aspectos de algunas industrias tradicionales, que la gente no siempre relaciona con el término tecnología; tal es el caso del mundo textil y del calzado, y de los sectores alimenticio, sanitario, automotriz y edilicio.

lunes, 28 de septiembre de 2015

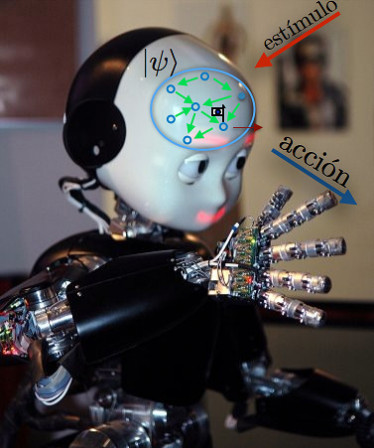

LA ROBÓTICA CUÁNTICA

LA ROBÓTICA CUÁNTICA

La computación cuántica permitirá crear potentes ordenadores, pero también robots mucho más inteligentes y creativos que los clásicos. Así lo asegura un estudio de investigadores de la Universidad Complutense de Madrid (UCM) y de Austria, que han confirmado como las herramientas cuánticas ayudan a los robots a aprender y responder mucho más rápido a los estímulos de su entorno.

La mecánica cuántica ha revolucionado el mundo de las comunicaciones y los ordenadores por la introducción de algoritmos mucho más veloces y seguros en la transferencia de información. Ahora investigadores de la Universidad Complutense de Madrid (UCM) y la Universidad de Innsbruck (Austria) publican un trabajo en la revista Physical Review X donde aseguran que sus mismas herramientas se pueden aplicar a los robots, los autómatas y demás agentes que usa la Inteligencia Artificial (IA).

Los robots cuánticos se adaptan a situaciones donde los clásicos no terminan los procesos de aprendizaje y respuesta

Por primera vez demuestran que las máquinas cuánticas pueden responder de forma óptima y más rápida a la hora de actuar frente al entorno que las rodea. En concreto, que se adaptan a situaciones donde las clásicas, más lentas, no llegan a terminar los procesos de aprendizaje y respuesta.

“En el caso de entornos muy exigentes e ‘impacientes’, el resultado es que el robot cuántico puede adaptarse y sobrevivir, mientras que el robot clásico está destinado a desfallecer”, explican G. Davide Paparo y Miguel A. Martín-Delgado, los dos investigadores de la UCM que han participado en el estudio.

Un robot cuántico puede ser más rápido y eficaz que uno clásico en entornos muy exigentes. / Ilustración adaptada de imagen de Lorenzo Natale

Su trabajo teórico se ha centrado en acelerar de forma cuántica uno de los puntos más difíciles de resolver en informática: el aprendizaje robótico (machine learning, en inglés), que se utiliza para elaborar modelos y predicciones muy precisas. Se aplican, por ejemplo, para conocer la evolución del clima, las enfermedades o en el desarrollo de los motores de búsqueda por internet.

Robots cuánticos más creativos

“Construir un modelo es realmente un acto creativo, pero los ordenadores clásicos no son buenos en esto –dice Martin-Delgado–. Ahí es donde entra en juego la computación cuántica. Las ganancias que aporta no son solo cuantitativas en cuanto a mayor velocidad, también cualitativas, al adaptarse mejor a entornos donde el agente clásico no sobrevive. Es decir, los robots cuánticos son más creativos”.

Los autores valoran así el alcance de su estudio: “Significa un paso adelante hacia el objetivo más ambicioso de la inteligencia artificial: la creación de un robot que tenga inteligencia y creatividad, y que no esté diseñado para tareas específicas”.

Este trabajo se enmarca dentro de una disciplina nueva, la denominada ‘inteligencia artificial cuántica’ (Quantum AI), un ámbito en el que la compañía Google ha comenzado a invertir millones de dólares mediante la creación de un laboratorio especializado en colaboración con la NASA.

El mercado de la robótica y las perspectivas futuras

El mercado de la robótica y las perspectivas

futuras

Las ventas anuales para robots industriales han ido creciendo en Estados

Unidos a razón del 25% de acuerdo a estadísticas del año 1981 a 1992. El

incremento de ésta tasa se debe a factores muy diversos. En primer lugar, hay

más personas en la in

En tercer lugar, que crece el mercado, son previsibles economías de

escala en la producción de robots para proporcionar una reducción en el precio

unitario, lo que haría los proyectos de aplicaciones de robots más fáciles de

justificar. En cuarto lugar se espera que el mercado de la robótica sufra una

expansión más allá de las grandes empresas, que ha sido el cliente tradicional

para ésta tecnología, y llegue a las empresas de tamaño mediano, pequeño y por

que no; las microempresas. Estas circunstancias darán un notable incremento en

las bases de clientes para los robots.

La robótica es una tecnología con futuro y también para el futuro. Si

continúan las tendencias actuales, y si algunos de los estudios de investigación

en el laboratorio actualmente en curso se convierten finalmente en una

tecnología factible, los robots del futuro serán unidades móviles con uno o más

brazos, capacidades de sensores múltiples y con la misma potencia de

procesamiento de datos y de cálculo que las grandes computadoras actuales.

Serán capaces de responder a ordenes dadas con voz humana. Así mismo serán

capaces de recibir instrucciones generales y traducirlas, con el uso de la

inteligencia artificial en un conjunto específico de acciones requeridas para

llevarlas a cabo. Podrán ver, oír, palpar, aplicar una fuerza media con

precisión a un objeto y desplazarse por sus propios medios.

En resumen, los futuros robots tendrían muchos de los atributos de los

seres humanos. Es difícil pensar que los robots llegarán a sustituir a los

seres humanos en el sentido de la obra de Carel Kapek, Robots

Universales de Rossum. Por el contrario, la robótica es una tecnología que

solo puede destinarse al beneficio de la humanidad. Sin embargo, como otras

tecnologías, hay peligros potenciales implicados y deben establecerse

salvaguardas para no permitir su uso pernicioso.

El paso del presente al futuro exigirá mucho trabajo de ingeniería

mecánica, ingeniería electrónica, informática, ingeniería industrial,

tecnología de materiales, ingenierías de sistemas de fabricación y ciencias

sociales. 18. Proyecto quetzalcoatl Introducción

La Sociedad actual se encuentra inmersa en una Revolución Tecnológica,

producto de la invención del transistor semiconductor en 1951 ( fecha en la que

salió al mercado ). Este acontecimiento ha provocado cambios trascendentales

así como radicales en los ámbitos sociales, económicos, y políticos del orbe

mundial.

Ésta Revolución da origen a un gran número de ciencias multidiciplinarias;

este es el caso de la Robótica.La Robótica es una ciencia que surge

a finales de la década de los 50´s, y que a pesar de ser una ciencia

relativamente nueva, ha demostrado ser un importante motor para el avance

tecnológico en todos los ámbitos ( Industria de manufactura, ciencia, medicina,

industria espacial; etc.), lo que genera expectativas muy interesantes para un

tiempo no muy lejano.

Sin embargo es en la Industria de Manufactura donde la Robótica

encuentra un campo de aplicación muy amplio, su función es la de suplir la mano

de obra del Hombre en aquellos trabajos en los que las condiciones no son las

óptimas para este ( minas, plantas nucleares, el fondo del mar; etc.), en

trabajos muy repetitivos y en inumerables acciones de trabajo.

Debido al alto costo que representa el automatizar y robotizar un

proceso de producción, la tendencia actual en Robótica es la investigación de

microrobots y robots móviles autónomos con un cierto grado de inteligencia,

este último es el campo en el que se basa este proyecto de investigación.

Por lo anteriormente expuesto se explica la necesidad y la importancia

de que Institutos de Investigación, Centros Tecnológicos, la Industria Privada

en coordinación con las Universidades se den a la tarea de destinar recursos

tanto económicos y humanos para aliviar el rezago tecnológico que el país

padece.

Cabe hacer mención que este proyecto fue financiado por el Centro de

Investigación y Estudios Avanzados del IPN (CINVESTAV). ¿ QUE ES UN ROBOT ?

Un robot puede ser visto en diferentes niveles de sofisticación, depende

de la perspectiva con que se mire. Un técnico en mantenimiento puede ver un

robot como una colección de componentes mecánicos y electrónicos; por su parte

un ingeniero en sistemas puede pensar que un robot es una colección de

subsistemas interrelacionados; un programador en cambio, simplemente lo ve como

una máquina ha ser programada; por otro lado para un ingeniero de manufactura

es una máquina capaz de realizar un tarea específica. En contraste, un

científico puede pensar que un robot es un mecanismo el cuál él construye para

probar una hipótesis.

Un robot puede ser descompuesto en un conjunto de subsistemas

funcionales: procesos, planeación, control, sensores, sistemas eléctricos, y

sistemas mecánicos. El subsistema de Software es una parte implícita de los

subsistemas de sensores, planeación, y control; que integra todos los

subsistemas como un todo.

En la actualidad, muchas de las funciones llevadas acabo por los

subsistemas son realizadas manualmente, o de una forma off-line, pero en un

futuro las investigaciones en estos campos permitirán la automatización de

dichas tareas.

El Subsistema de Procesos incluye las tareas que lleva acabo el robot,

el medio ambiente en el cual es colocado, y la interacción entre este y el

robot. Este es el dominio de la ingeniería aplicada. Antes de que un robot

pueda realizar una tarea, ésta debe ser buscada dentro de una secuencia de

pasos que el robot pueda ejecutar. La tarea de búsqueda es llevada acabo por el

Subsistema de Planeación, el cuál incluye los modelos de procesos inteligentes,

percepción y planeación. En el modelo de procesos, los datos que se obtienen de

una variedad de sensores son fusionados (Integración Sensorial) con modelos

matemáticos de las tareas para formar un modelo del mundo. Al usar este modelo

de mundo, el proceso de percepción selecciona la estrategia para ejecutar la

tarea. Estas estrategias son convertidas dentro de los programas de control de

el robot durante el proceso de planeación.

Estos programas son ejecutados por el Subsistema de Control; en este

subsistema, los comandos de alto nivel son convertidos en referencias para

actuadores físicos, los valores retroalimentados son comparados contra estas

referencias, y los algoritmos de control estabilizan el movimiento de los

elementos físicos.

Al realizar ésta tarea los mecanismos son modelados, el proceso es

modelado, la ganancia de lazo cerrado puede ser adaptada, y los valores medidos

son utilizados para actualizar los procesos y los modelos de los mecanismos.

Desde el subsistema de control se alimentan las referencias de los

actuadores al Subsistema Eléctrico el cuál incluye todos los controles

eléctricos de los actuadores. Los actuadores hidráulicos y neumáticos son

usualmente manejados por electroválvulas controladas. También, este subsistema

contiene computadoras, interfaces, y fuentes de alimentación. Los actuadores

manejan los mecanismos en el Subsistema Mecánico para operar en el medio

ambiente, esto es, realizar una tarea determinada. Los parámetros dentro del

robot y del medio ambiente son monitoreados por el Subsistema de Sensores; ésta

información sensórica se utiliza como retroalimentación en las ganancias de

lazo cerrado para detectar potencialmente las situaciones peligrosas, para

verificar que las tareas se realizan correctamente, y para construir un modelo

del mundo.

VEHÍCULOS

La mayoría de los robots usan ya sea ruedas o extremidades para moverse.

Estas son usualmente montadas sobre una base para formar un vehículo, también

se montan sobre ésta base, el equipo y los accesorios que realizan otras

funciones. Los robots más versátiles son los robots "serpentina";

llamados así por que su locomoción se inspira en el movimiento de las

serpientes; se pueden utilizar en terrenos subterráneos y de espacios

reducidos, donde el hombre no tiene acceso y el medio ambiente no es el más

propicio, como en las minas, túneles y ductos.

Algunos robots móviles tienen brazos manipuladores, esto es debido a sus

funciones, y por otro lado la problemática de carecer de brazos idóneos; que

tienen que ser pequeños, fuertes, eficientes y baratos. Un problema al cuál se

enfrentan los diseñadores de robots, es la generación y almacenado de la

energía; los cordones restringen el movimiento pero proveen energía ilimitada.

En contraste los robots con libre movimiento son limitados por su

cantidad de energía que puedan almacenar y requieren de comunicación

inalámbrica.

En la medida que los robots sean más sofisticados, serán utilizados en

un mayor número de aplicaciones, muchas de las cuáles requieren movilidad. En

algunas aplicaciones industriales, la necesidad de movilidad es eliminada por

la construcción de células de trabajo alrededor del robot, de ésta manera un

robot fijo puede dar servicio a varias máquinas. En estos sistemas de

manufactura flexible (SMF) las partes son llevadas de una célula de trabajo a

otra por vehículos autómatas. En ocasiones para limitar el movimiento del robot

se monta sobre rieles para así llegar hasta las células de trabajo con menos

complicaciones.

La movilidad es usualmente llevada acabo mediante ruedas, rieles ó

extremidades. Los robots con extremidades pueden andar en terrenos más rugosos

que los robot con rodado, pero el problema de control es más complejo. Los

robots pueden alcanzar movilidad volando. Algunos se deslizan ligeramente sobre

al tierra sobre conductos de aire; otros usan levitación magnética, para lo que

se requieren superficies especialmente preparadas.

Los robots diseñados para usos en el espacio exterior no son afectados

por la gravedad; se elimina el problema de levitación, pero se incrementa el

problema del control y la estabilidad.

VEHÍCULOS DE RODADO

Mientras la gente y la mayoría de los animales se desplaza sobre

extremidades, la mayoría de las máquinas móviles utilizan ruedas. La ruedas son

más simples de controlar, tienen pocos problemas de estabilidad, usan menos

energía por unidad de distancia de movimiento y son más veloces que las

extremidades. La estabilidad se mantiene al fijar el centro de gravedad de el

vehículo en triangulación de los puntos que tocan tierra. Sin embargo, las

ruedas solamente pueden utilizarse sobre terrenos relativamente lisos y

sólidos. Si se quiere utilizar el robot en terrenos rugosos las ruedas tienen

que tener un tamaño mayor que los obstáculos encontrados.

El arreglo más familiar para las ruedas de un vehículo es el utilizado

por los automóviles. Cuatro ruedas son colocadas en las esquinas de un

rectángulo. La mayoría de estos vehículos tiene maniobrabilidad limitada debido

a que tienen que avanzar para poder dar vuelta. También se requiere de un

sistema de suspensión para asegurar que las ruedas estén en contacto con la

superficie durante todo el tiempo. Cuando el robot se desplaza en línea recta

las cuatro ruedas tienen que girar a la misma velocidad, en cambio al momento

de dar vuelta las ruedas interiores giran más lento que las ruedas exteriores.

En un robot móvil, estos requerimientos son alcanzados por un buen

diseño mecánico y mediante el control de la velocidad de las ruedas de

dirección independiente. Sin embargo las imprecisiones que se presentan para

alcanzar una trayectoria definida son causadas por factores mecánicos,

deslizamiento de las ruedas, dobleces en los ejes de dirección, y

desalineamiento de las ruedas. ¿EN QUE CONSISTE EL PROYECTO QUETZALCÓATL?

OBJETIVOS

- Construir el prototipo de un

Robot Móvil Autónomo para propósitos didácticos y/o para prueba y

verificación de algoritmos de control. Y dejar, con este proyecto de investigación,

las bases para próximas mejoras en la optimización del prototipo.

- Crear nuevos investigadores

que cuenten con experiencia y habilidad en el desarrollo de

investigaciones y realización de proyectos de este tipo.

- Motivar y crear bases para

el desarrollo de más proyectos didácticos y/o aplicados a la industria.

- Crear vínculos con otras

instituciones de enseñanza superior en el Estado con la Universidad de

Guadalajara.

METODOLOGÍA DEL DISEÑO

El proyecto consta básicamente de cuatro etapas; Etapa de Investigación, Etapa de Síntesis Informativa, Etapa de Diseño y Construcción, Etapa de pruebas, calibración y control. A).- Etapa de Investigación.

a) Adquisición de Bibliografía.

El proyecto consta básicamente de cuatro etapas; Etapa de Investigación, Etapa de Síntesis Informativa, Etapa de Diseño y Construcción, Etapa de pruebas, calibración y control. A).- Etapa de Investigación.

a) Adquisición de Bibliografía.

b) Búsqueda de las fuentes de información específicas de aquellos

elementos que constituyen el prototipo.

c) Investigación de las variables que intervienen en el proceso de

control del prototipo.

d) Adquisición y estudio del software para el desarrollo e

implementación de los algoritmos de control. B).- Etapa de Síntesis de la

Información.

Ésta etapa se basa en la etapa anterior y da como resultado una serie de elementos que son necesarios para el desarrollo de las siguientes etapas de el proyecto. C).- Etapa de Diseño y Construcción.

En ésta etapa se aplica toda la información que se recaba y consulta, y que el diseño del prototipo requiere para el cumplimiento de los objetivos planteados anteriormente. En base a estos lineamientos se construyen las piezas que conforman el prototipo, con el material y componentes adecuados. D).- Etapa de Pruebas, Calibración y Control.

Ésta es la etapa final, se adoptan las medidas necesarias para alcanzar los objetivos planteados. Se aplican los algoritmos de control y se prueban hasta conseguir el resultado esperado. DESCRIPCIÓN DEL PROYECTO

El sistema propuesto consta de :

Un Robot Móvil Autónomo.

Se encuentra formado por 2 módulos unidos entre sí mediante una unión

mecánica, la locomoción del prototipo se realiza por medio de dos ruedas en

cada eslabón, en donde cada una de las que son parte de el primer eslabón

cuenta con un actuador ( motorreductor de DC ).

Los servosistemas se componen de un Driver tipo Chopper con control en

lazo cerrado de velocidad, para cada actuador en forma independiente.

La alimentación del Robot se realiza mediante módulos de baterías de 12

V y los voltajes se adaptan por medio de convertidores DC-DC.

La información del entorno donde se mueve el Robot se recaba mediante

sensores ultrasónicos, los cuales cuentan con una tarjeta de interfaz, la cual

pasa dicha información al Cerebro del Robot.

Debido a la complejidad del proyecto, este se descompone en un conjunto

de subsistemas que son: - Subsistema Mecánico.

Este subsistema incluye los eslabones, las uniones mecánicas y el módulo que contiene a todo el sistema que permite que las ruedas giren ( ruedas, ejes, coples, baleros). - Subsistema Eléctrico

Este subsistema incluye los servosistemas ( Drivers ), las interfaces entre los sensores, los drivers y la computadora, así como las fuentes de alimentación.

Este subsistema incluye los eslabones, las uniones mecánicas y el módulo que contiene a todo el sistema que permite que las ruedas giren ( ruedas, ejes, coples, baleros). - Subsistema Eléctrico

Este subsistema incluye los servosistemas ( Drivers ), las interfaces entre los sensores, los drivers y la computadora, así como las fuentes de alimentación.

-Subsistemas de Sensores

Ésta incluye los sensores de velocidad de tipo incremental, y sensores ultrasónicos para la exploración del medio ambiente. - Subsistemas de Procesos, Planeación y Control

En este subsistema se encuentran el control de los motores y todas las tareas que realiza el prototipo interiormente y exteriormente al interactuar con el medio ambiente

Ésta incluye los sensores de velocidad de tipo incremental, y sensores ultrasónicos para la exploración del medio ambiente. - Subsistemas de Procesos, Planeación y Control

En este subsistema se encuentran el control de los motores y todas las tareas que realiza el prototipo interiormente y exteriormente al interactuar con el medio ambiente

Suscribirse a:

Entradas (Atom)